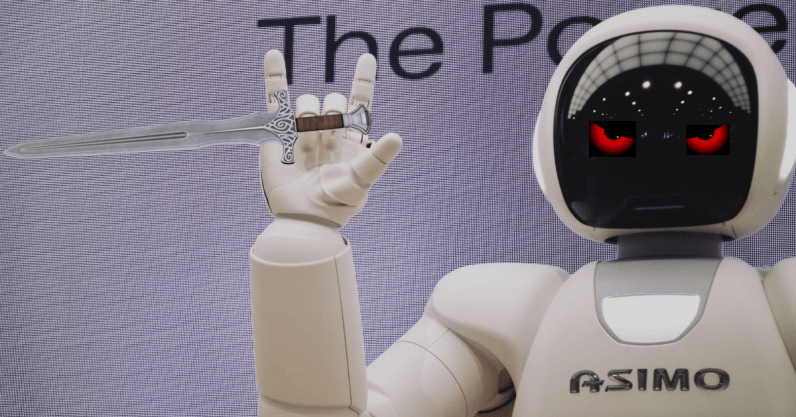

تسليح الذكاء الصنعي – هل نحن بحاجة إلى حظر “الروبوتات القاتلة”

شرخ عميق في النقاش يظهر حول تسليح الذكاء الصنعي أو ما يسمى بـ “الروبوتات القاتلة”. فالعديد من الدول ترغب بأن ترى قانوناً دولياً جديداً بشأن أنظمة الأسلحة المستقلة التي يمكنها استهداف وقتل الأشخاص دون التدخل البشري. ولكن الدول التي تطور مثل هذه الأسلحة بالفعل تحاول إبراز فوائدها المفترضة بدلاً من اقتراح القيود المحددة لتطويرها.

وقد بدت هذه الفجوة المتنامية في اجتماع الأمم المتحدة الأخير لأكثر من 70 دولة في جنيف، حيث كان المؤيدون للأسلحة ذاتية الحكم أو المستقلة، بما في ذلك الولايات المتحدة وأستراليا وكوريا الجنوبية، أكثر صراحة من أي وقت مضى. وفي الاجتماع، زعمت الولايات المتحدة أن مثل هذه الأسلحة يمكن في الواقع أن تجعل من السهل متابعة القانون الدولي الإنساني من خلال جعل العمل العسكري أكثر دقة.

ومع ذلك، فإنه من النفاق القول بأن “الروبوتات القاتلة” ستتمكن من تطبيق القانون الإنساني على الإطلاق. وبينما يستمر السياسيون في الجدل حول هذا الموضوع فإن انتشار الحكم الذاتي والذكاء الصنعي في التكنولوجيا العسكرية الحالية يضع بالفعل معايير غير مرغوبة لدوره في استخدام القوة.

وقد ساعدت سلسلة من الرسائل المفتوحة من قبل باحثين بارزين ضد تسليح الذكاء الصنعي، في طرح النقاش حول الأنظمة العسكرية المستقلة إلى الاهتمام العام. وتكمن المشكلة في أنَّ النقاش المطروح يفترض أنَّ هذه التكنولوجيا ستكون شيء من المستقبل.

وفي الواقع، عسكرياً معظم أنظمة الدفاع الجوي والجيوش تتمتع باستقلالية كبيرة في عملية تسليح الذكاء الصنعي وتطويره، وتتميز الطائرات العسكرية بميزات تلقائية عالية. وهذا يعني أن “الروبوتات” بدأت تشارك بالفعل في تحديد الأهداف.

راجع هذه: الذكاء الصنعي يحتاج لمراقبة ضمان الجودة

وفي الوقت نفسه، هنالك سؤال مهم تُثيره التكنولوجيا الحالية وهو مفقود حالياً من المناقشة الجارية. فالطائرات بدون طيار والتي تعمل عن بعد تستخدم من قبل العديد من الدول والقوى العسكرية لإسقاط القنابل على الأهداف. ولكننا نعرف من الحوادث في أفغانستان وأماكن أخرى أنَّ صور الطائرات بدون طيار ليست كافية للتمييز الواضح بين المدنيين والمقاتلين. ونعلم أيضاً أن تقنية الذكاء الصنعي الحالية يمكن أن تحتوي على تحيز ولغط كبير قد يؤثر على اتخاذ القرار، وغالباً ما يكون له تأثيرات ضارة.

وبما أنه من المرجح استخدام الطائرات المستقلة بالكامل صاحبة القرار في المستقبل بطرق مشابهة للطائرات بدون طيار، فمن المرجح أنها ستتبع الممارسات التي وضعتها الطائرات بدون طيار، وبالتالي المزيد من الأخطاء وفقدان السيطرة.

صنع القرار غير المرئي

وبشكلٍ عميق أكثر، مع تزايد اختيار الأهداف والاعتداء عليها من قبل الالآت، تقل معرفتنا بكيفية اتخاذ هذه القرارات. فالطائرات بدون طيار تعتمد بشدة على بيانات المخابرات التي تتم معالجتها بواسطة خوارزميات “الصندوق الأسود” التي يصعب فهمها لأختيار أهدافها المقترحة. وهذا يجعل الأمر أكثر صعوبة بالنسبة للمشغلين البشر الذين يضغطون في الواقع على الزناد لاستجواب المقترحات المستهدفة.

ومع استمرار الأمم المتحدة في مناقشة قضية تسليح الذكاء الصنعي تجدر الإشارة إلى أن معظم الدول المؤيدة لحظر الأسلحة المستقلة هي دول نامية، والتي عادة ما تكون أقل فرصاً لحضور محادثات نزع السلاح الدولية. لذا فإن حقيقة استعدادهم للتحدث بقوة ضد الأسلحة المستقلة يجعلهم أكثر أهمية. وتاريخهم في تجربة التدخلات والغزوات من الدول الأكثر ثراءً والأكثر قوة (مثل بعض الدول المؤيدة للأسلحة ذاتية الحكم) يذكرنا أيضاً بأنهم أكثر عرضة للخطر من هذه التكنولوجيا.

وبالنظر إلى ما نعرفه عن الأنظمة المستقلة القائمة، ينبغي أن نكون قلقين للغاية من أن “الروبوتات القاتلة” ستجعل انتهاكات القانون الإنساني أكثر احتمالاً، وليس أقل. ولا يمكن منع هذا التهديد إلا بالتفاوض على قانون دولي جديد يحد من استخدامها.

راجع أيضاً: